首页 > 医疗资讯/ 正文

摘 要

基于人工智能(artificial intelligence,AI)和机器学习(ML)方法的临床预测模型开发和验证研究日益广泛,于2019年开发的预测模型偏倚风险和适用性评价工具(prediction model risk of bias assessment tool,PROBAST)-2019展现出明显的局限性。因此,2025年发布PROBAST-2019的扩展更新版本,即PROBAST+AI。该工具分为模型开发和模型评估部分,旨在全面、规范评价模型开发中潜在的方法学质量问题、模型评估中的偏倚风险及适用性。本文对PROBAST+AI工具进行系统性的条目解读和示例分析,以期为从事相关研究的科研人员提供指导和帮助,促进临床预测模型研究的高质量发展。

正 文

临床预测模型对于辅助临床决策、优化医疗实践具有重要意义[1-4]。在精准医疗时代,随着数据科学不断革新,每年都会有数以千计的临床预测模型研究,例如仅心血管领域的预测模型就有1 000余种[5]。尽管目前已发布临床预测模型研究的报告规范(TRIPOD-2015[6]及其更新版本TRIPOD+AI[7]、基于大语言模型的报告指南TRIPOD-LLM[8-9]),但是既往证据表明,预测模型研究普遍存在报告规范性及完整性不足、模型偏倚程度较高、适用性及可移植性低下等问题[3,10-12],模型开发及验证过程中的样本量问题、方法学缺陷及潜在的公平性问题等均严重影响预测性能的真实性和可靠性[13-14]。

为全面评估预测模型研究的质量及模型性能、厘清模型的预期用途和适用范围以及避免研究资源的浪费,Karel GM Moons团队于2019年开发PROBAST工具[15]以评估偏倚风险和适用性(以下简称PROBAST-2019)。随着人工智能(artificial intelligence,AI)特别是机器学习(machine learning,ML)技术的进步和普及,建模方法逐渐从传统回归拓展至AI/ML领域,并涌现出大量基于AI/ML技术的临床预测模型。鉴于PROBAST-2019重点关注传统回归模型且不能完全适用于最新进展,Karel GM Moons团队于2025年3月在BMJ上发布可以同时针对传统回归模型和AI/ML模型的评价工具(即PROBAST+AI)[14]。本文对PROBAST+AI工具的开发过程、评价内容及使用方法进行解读,以期为国内学者提供新的借鉴和帮助。

1 PROBAST+AI工具开发过程

PROBAST+AI工具的开发过程经历了以下几个阶段。第一阶段:2021年发布开发PROBAST+AI的声明[16],成立在预测模型研究、系统评价和PROBAST-2019应用方面经验丰富的工作组,负责监督指导开发过程。第二阶段:形成候选域和标志性问题。2020年10月,对50多位具有PROBAST-2019应用经验的研究者开展调查,内容包含对PROBAST-2019的使用体验、其在AI/ML预测模型研究中的适用性、对现有领域和标志性问题的改进建议或措辞调整以及是否需要删除或添加。整合所有建议后形成分布在4个领域包含26个标志性问题的初始清单,并以此作为第一轮德尔菲调查的基础。第三阶段:招募德尔菲参与者。工作组通过多种途径招募参与者,确保参与者的学科和地域多样性。第四阶段:德尔菲调查。第一轮于2021年7月12日—9月12日进行,201位受邀者中95位完成调查。第二轮于2023年1月20日—3月10日进行,294受邀者中132位完成调查。第二轮调查明确区分模型开发更关注质量评估(21项问题),模型评估更关注偏倚风险评估(22项问题)。第三轮于2023年5月11日—7月7日进行,299位受邀者中118位完成调查。第三轮调查确定了用于模型开发的18项条目和用于模型评估的19项条目。第五阶段:共识会议。由Karel GM Moons、Johanna AA Damen等主持的混合式共识会议于2023年10月17日召开,29位受邀者中有26位出席。会议着重对第三轮调查后经重新措辞或新添加的10项问题进行讨论和投票,协商一致后开发了最终PROBAST+AI工具。

2 PROBAST+AI工具的内容和适用范围

ROBAST+AI工具包含模型开发和模型评估部分。使用16个标志性问题评估模型开发部分的研究质量和适用性;使用18个标志性问题评估模型评估部分的偏倚风险和适用性。两部分均包含4个领域:研究对象和数据来源、预测因子、结果以及数据分析。研究者可在 PROBAST网站上查询和下载该工具。

PROBAST+AI应取代PROBAST-2019工具,允许所有相关人员评估任何类型的诊断或预后模型的质量、偏倚风险和适用性。无论使用何种预测因子、预测何种结果、使用传统回归或AI/ML建模方法,均可使用该工具进行评价。该工具不适用于预测因子发现研究、预测模型的比较和定性研究。

3 PROBAST+AI工具使用步骤

3.1 步骤1:明确预测模型评估或系统评价的预期目的

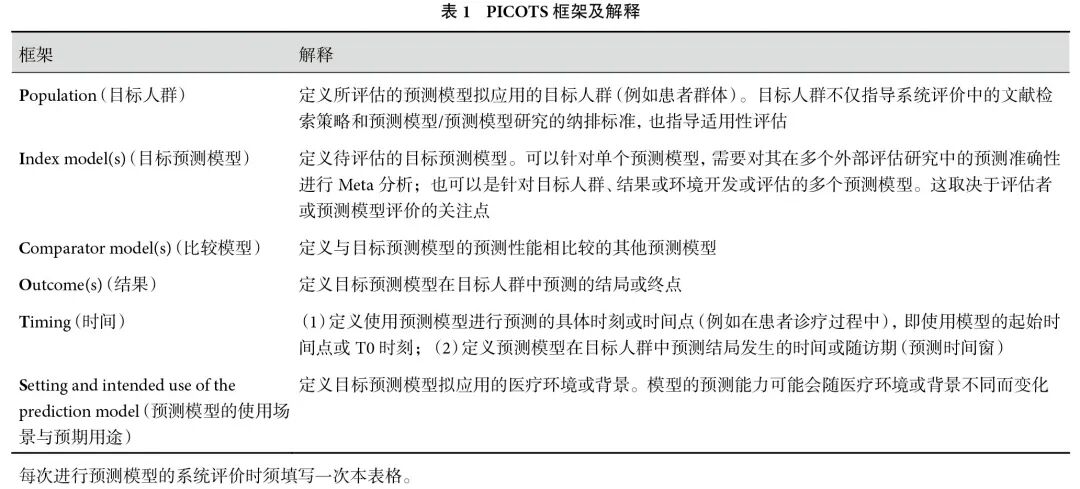

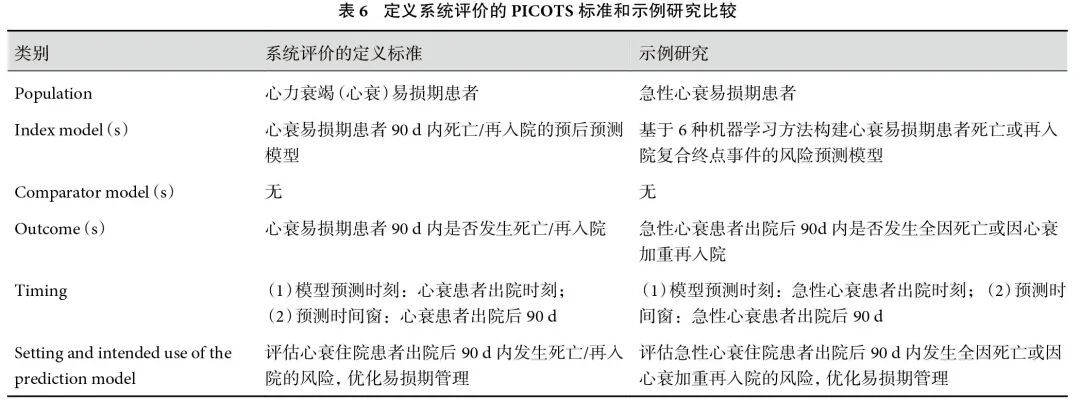

推荐使用Cochrane预后方法学组所提供的PICOTS指南,通过定义PICOTS标准明确评估预测模型的预期目的及拟进行系统评价的问题,PICOTS的框架及解释见表1。

3.2 步骤2:对预测模型研究分类

PROBAST+AI对模型开发和评估分别提供了不同的标志性问题,因此,评价者须明确预测模型研究的类型。研究类型包含模型开发、模型评估或两者兼有。模型评估包括对表观性能、内部验证性能和外部验证性能的逐一评估[表观性能:使用与模型开发时完全相同的数据集进行评估的性能;内部验证性能:使用开发数据集但经过内部验证(如重采样)后评估的性能;外部验证性能:使用未曾用于模型开发的外部数据集进行评估的性能 ]。若研究侧重于更新现有模型,比如添加一个或多个预测因子,可参考模型开发部分;若仅聚焦于现有模型在外部数据集中的性能表现,则仅使用模型评估部分。

3.3 步骤3:评价各领域预测模型的质量、偏倚风险和适用性

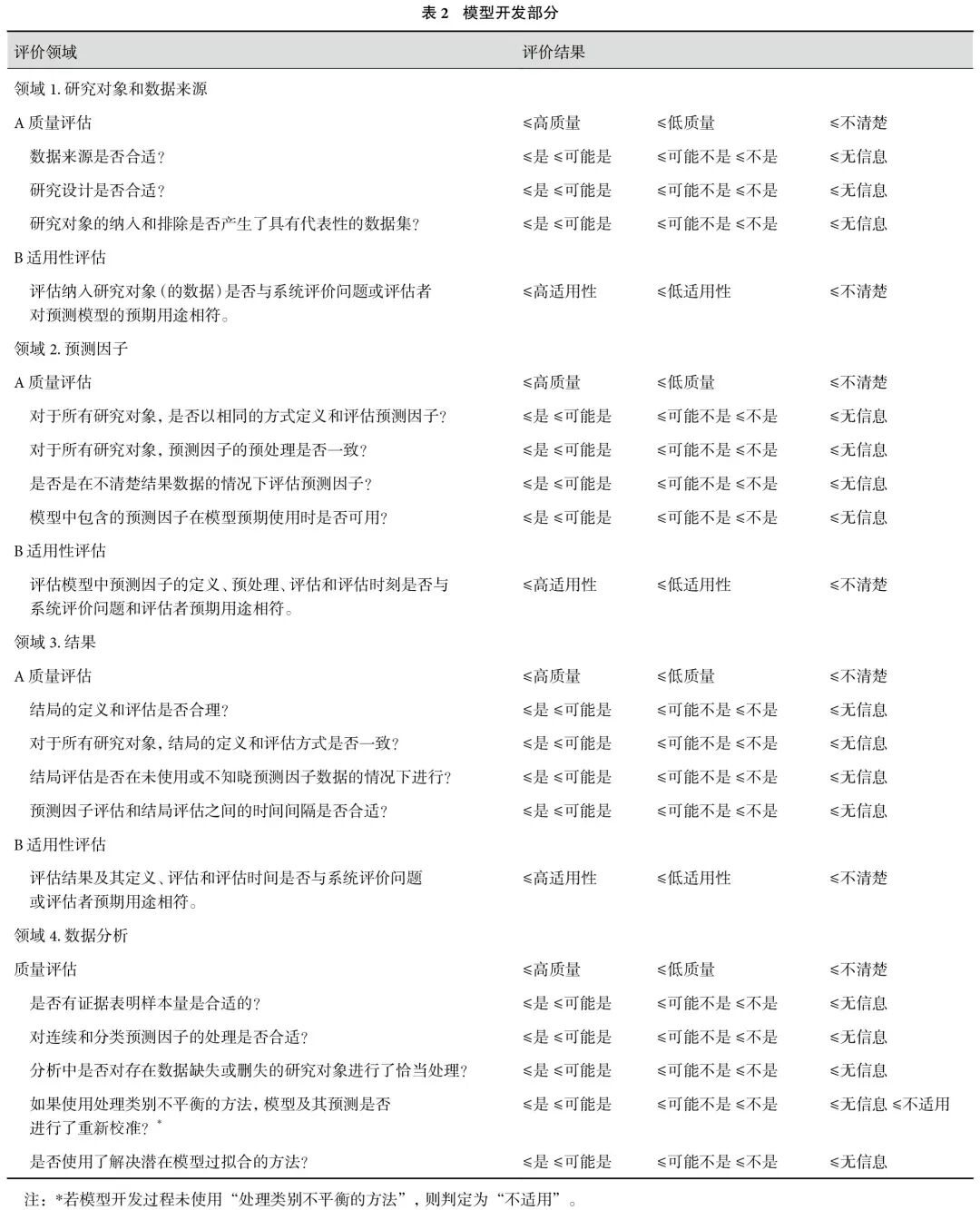

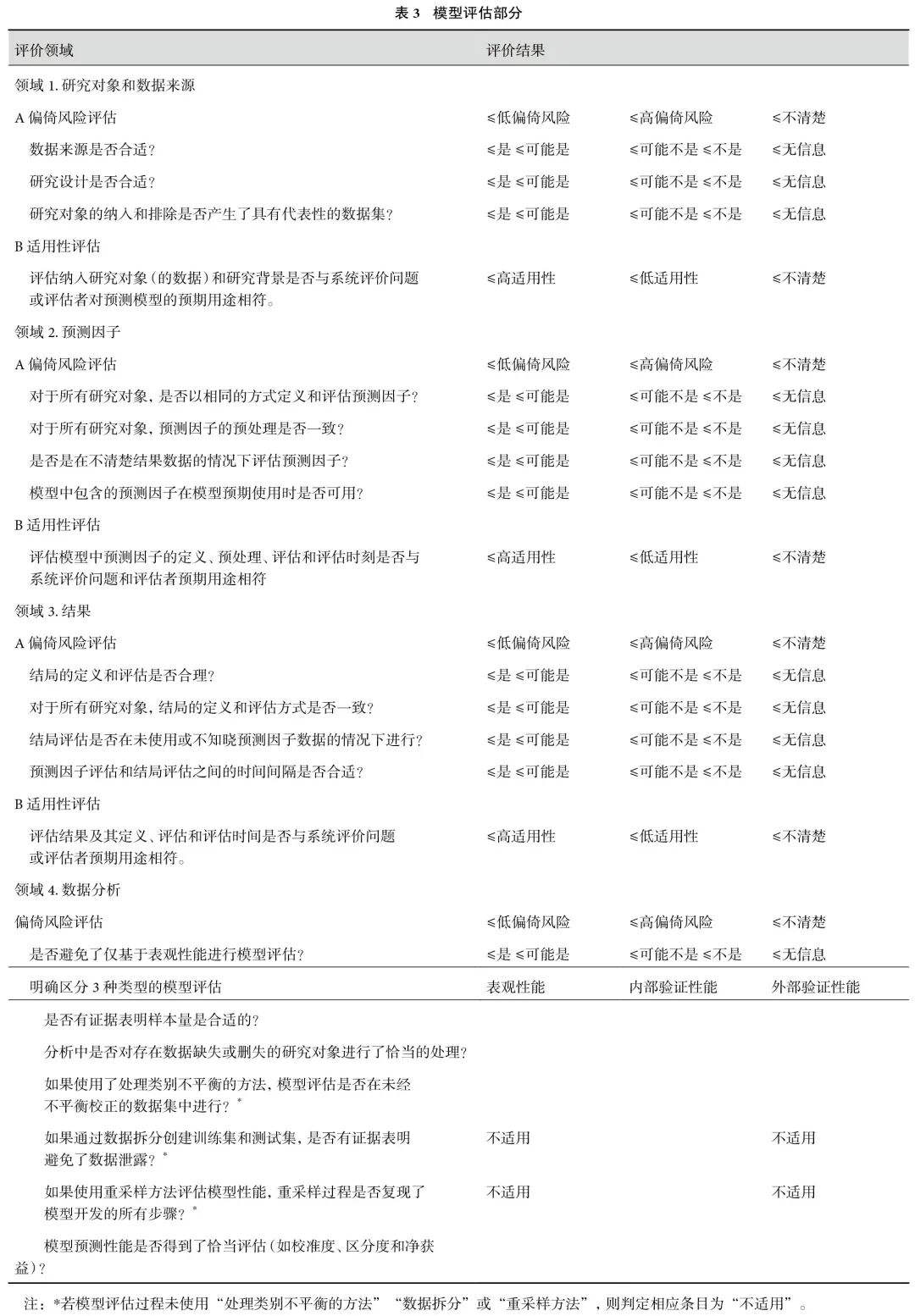

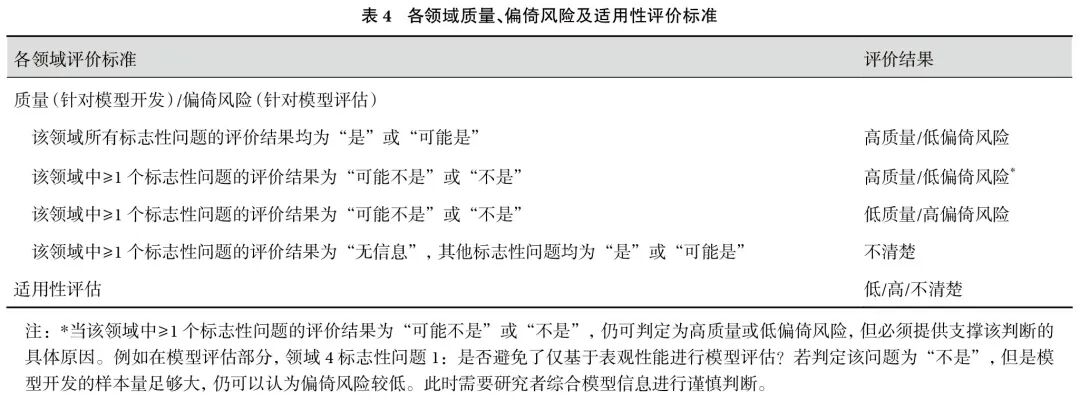

本步骤旨在确定预测模型研究中可能存在质量、偏倚风险以及适用性问题的领域。4个领域的标志性问题均采用“是”“可能是”“可能不是”“不是”“无信息”或“不适用”(标有*的条目)进行回答;每个领域中,针对模型开发的质量评价和模型评估的偏倚风险评价均被判断为“低”“高”或“不清楚”。问题被标记“是”或“可能是”表明质量较高或偏倚风险较低;反之则表明存在质量问题或偏倚风险。需要注意,当某个问题的回答为否定,不一定直接导致该领域的质量较低或偏倚风险较高,这需要评价者综合预测模型的信息进行仔细判断并说明具体原因。当研究中的信息不足以进行判断时,可使用“无信息”。

前3个领域还需根据系统评价的问题或模型的预期用途判断适用性的“低”“高”或“不清楚”。标志性问题的评价内容见表2和表3,各领域的评价标准见表4。各领域标志性问题的解释和阐述见附表1~3,研究者应仔细阅读解释和阐述文件以帮助做出正确判断。

3.4 步骤4:整体质量、偏倚风险和适用性评价

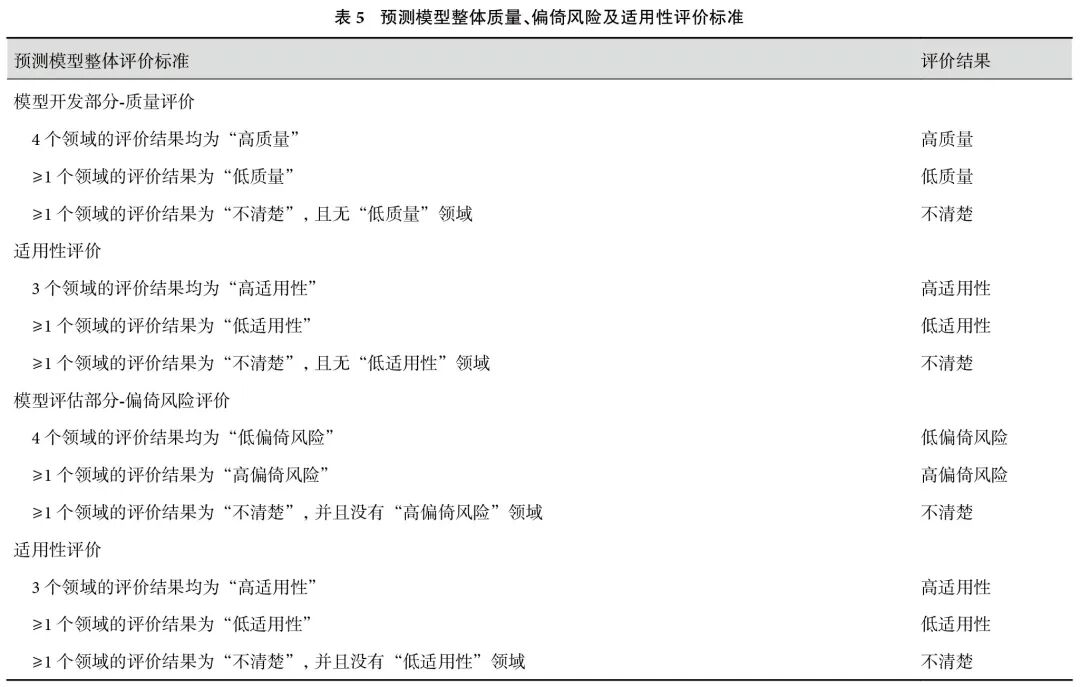

综合步骤3中4个领域的评价结果,对预测模型开发部分的质量和适用性以及模型评估部分的偏倚风险和适用性进行整体判断(低、高或不清楚)。整体判断的标准见表5。

4 PROBAST+AI工具各领域条目解读

4.1 模型开发部分

4.1.1 领域1:研究对象和数据来源

质量评估 (1)标志性问题1:数据来源可追溯时判断为“是/可能是”;数据来源于公共数据库或缺少研究对象抽样和测量的足够细节时,会增加质量问题。(2)标志性问题2:预后模型采用前瞻性队列设计/随机治疗试验或诊断模型采用横断面设计可判断为“是/可能是”;针对病例对照或巢式病例对照设计采用逆抽样分数重新加权后可判断为“是/可能是”;未校正的病例对照或巢式病例对照设计以及数据来源于现有数据集、常规诊疗数据会导致质量问题。若未报告充足信息,则判断为“无信息”。(3)标志性问题3:选择性招募研究对象会导致与目标使用人群不符的非代表性数据集。在开发诊断模型时排除难以诊断的对象、开发预后模型时纳入已知结局的对象、明确排除或过采样特定边缘化亚组,均可判断为“可能不是/不是”。若未报告充足信息,则判断为“无信息”。

适用性评估 纳入的研究对象及其数据与系统评价问题或预测模型的预期用途相符,判断为“高适用性”;反之为“低适用性”,未报告相关信息判定为“不清楚”。基于随机治疗试验的预测模型研究由于纳排标准更严格、预测因子更少和随访时间更短等问题,其适用性评价须仔细考量。

4.1.2 领域2:预测因子

质量评估 (1)标志性问题1:对于所有研究对象,预测因子的定义、分类阈值和评估方法应保持统一,对于边缘化亚组也要保持一致,此时判断为“是/可能是”,否则判断为“可能不是/不是”。若预测因子依赖主观判断或特殊测量技能会导致质量问题,必要时须明确测量人员的资质。未报告充足信息,判断为“无信息”。(2)标志性问题2:对于所有研究对象,预测因子的预处理一致时,可判断为“是/可能是”;同一预测因子的预处理存在差异,判断为“可能不是/不是”;未报告充足信息,判断为“无信息”。(3)标志性问题3:当评估预测因子对结局设盲或明显早于结局评估(如前瞻性队列设计)时,判断为“是/可能是”。在回顾性评估预测因子的研究中结局可能已经发生,或者横断面研究中预测因子和结局在相对较短的时间内同时评估,这些情况会导致质量问题。未报告充足信息,判断为“无信息”。(4)标志性问题4:为使模型应用于实践,须确保该模型中包含的所有预测因子在预期使用时(即预测时刻)均可被评估,此时判断为“是/可能是”。未报告充足信息,判断为“无信息”。

适用性评估 模型中预测因子的定义、预处理、评估和评估时刻与系统评价问题或预期用途相符时,判断为“高适用性”;反之为“低适用性”;未报告充足信息判定为“不清楚”。过度依赖专业测量技术评估预测因子可能会降低模型在目标环境中的适用性。

4.1.3 领域3:结果

质量评估 (1)标志性问题1:结局的定义和评估方法为预先设定或被医学指南、已发表研究所证实的标准化方法,判断为“是/可能是”;采用非标准结局定义、依赖主观判断或特定测量技术、基于连续量表自行设定阈值或者依赖数据驱动获取最大结局发生率均会引发质量问题,应判定为“可能不是/不是”;对于复合结局,需仔细判断是否存在对结局组分的选择性纳入或排除;使用常规诊疗、疾病登记或公开数据时也要谨慎判断结局的定义和评估方法是否合适;未报告充足信息,则判断为“无信息”。(2)标志性问题2:对于所有研究对象,结局定义、分类阈值和测评方法应保持一致(对于边缘化亚组也是如此),判断为“是/可能是”;结局依赖主观判断或特定测量技术或数据来源于常规诊疗、疾病登记或公开数据时可能增加质量问题;在诊断模型研究中,存在部分结局验证和差异结局验证时,判定为“可能不是/不是”;未报告充足信息,判断为“无信息”。(3)标志性问题3:评估预测因子信息是否泄漏到结局评估中,判断方法与领域2的标志性问题3类似。(4)标志性问题4:本条目需要结合专业领域知识判断时间间隔是否过短或过长。预测因子和结局评估的时间间隔合理,判断为“是/可能是”,否则判断为“可能不是/不是”;未报告充足信息,则判断为“无信息”。

适用性评估 结局定义、评估方法和评估时间与系统评价问题或预期用途相符,则可判断“高适用性”,否则判断为“低适用性”;未报告充足信息,则判断为“不清楚”。

4.1.4 领域4:数据分析

质量评估 (1)标志性问题1:无论基于传统回归或AI/ML方法建模,样本量越大越好。评价者应谨慎使用经验法则(如10EPV)判断样本量是否充足;目前已有针对具有连续、二分类、多分类或生存结局的预测模型的最小样本量标准[17–19]。未提供有关样本量充足性的信息,判断为“无信息”。(2)标志性问题2:未对连续型预测因子分类(如二分法)、采用样条函数或分数多项式捕捉非线性关联、未随意删除或合并分类预测因子的某些类别、未采用数据驱动的变量分类以最大化预测性能、采用基于树的学习方法(如随机森林),可判断为“是/可能是”。(3)标志性问题3:避免因存在缺失值而排除研究对象,即使少量数据缺失或删失也可能对预测模型产生深远影响。多重插补法是处理缺失数据的优选方法[20],判断为“是/可能是”;因数据缺失直接剔除研究对象、未明确报告处理缺失数据的方法、方法存在缺陷或在边缘化亚组中存在差异,应判断为“可能不是/不是”。(4)标志性问题4:采用过采样、欠采样或合成少数类过采样技术(synthetic minority over-sampling technique,SMOTE)等方法校正结局状态,并通过重新加权或重新估计截距等方法重新校准模型,可判断为“是/可能是”;未重新校准判断为“可能不是/不是”。(5)标志性问题5:采用了解决潜在过拟合的方法,例如足够大的样本量、避免依赖数据驱动的预测因子筛选或应用正则化/收缩方法,判断为“是/可能是”;若未采用则判断为“可能不是/不是”;特别注意正则化/收缩方法不能代替充足的样本量[21–23],当样本量过小,即使应用了该方法,也可判断为“可能不是/不是”。未报告充足信息,判断为“无信息”。

4.2 模型评估部分

当进行一个或多个模型评估/验证时,须重新根据标志性问题判断每个领域的偏倚风险,并进行适用性判断。对每个模型所进行的每种类型的模型评估/验证研究,需单独评估领域4。

4.2.1 领域1~领域3

前3个领域的标志性问题、解释及其判断方法与模型开发部分基本一致,请参见前文4.1.1~4.1.3。开发特定模型后仅评价其表观性能和(或)内部验证性能,或又基于相同的开发数据集验证一个或多个其他模型,由于数据集是相同的,其定义、测评预测因子和结局的方式也是相同的,因此,模型评估部分和模型开发部分中,针对这3个领域及其标志性问题的判断和适用性判断通常是一致的。但是如果使用外部数据集评估模型的外部验证性能,通常需要重新评估领域1~领域3。

4.2.2 领域4:数据分析

偏倚风险评估 (1)标志性问题1:仅评估模型的表观性能,判断为“不是”;当样本量足够大时,即使本条目回答为“不是”,也可认为偏倚风险较低。(2)标志性问题2:用于模型评估的样本量过小时通常不能精确估计模型的真实性能,目前已有关于3种不同类型的模型评估所需的最小样本量指南。应谨慎使用经验法则(如在结局为二分类的预测模型研究中,至少需要100名发生预测事件的研究对象)进行判断。未提供有关样本量充足性的信息时,判断为“无信息”。(3)标志性问题3:判断方法与模型开发部分领域4的标志性问题3类似。(4)标志性问题4:模型评估在未经不平衡校正的验证数据集中进行,判断为“是/可能是”,反之可判断为“可能不是/不是”。(5)标志性问题5:本条只适用于内部验证。数据拆分后训练集和测试集存在数据重叠,或在训练集上重新调优参数,判断为“可能不是/不是”;反之可判断为“是/可能是”;未报告充足信息判断为“无信息”。(6)标志性问题6:本条只适用于内部验证。任何用于内部验证的重采样程序都应包含所有模型开发步骤,包括插补、变量选择、超参数调优和模型构建,此时判断为“是/可能是”,否则判断为“可能不是/不是”;未报告充足信息判断为“无信息”。(7)标志性问题7:校准度(校准图)和区分度(C指数)是重要的性能参数。仅报告其中一种或两者均缺失、仅使用拟合优度的统计检验(如Hosmer-Lemeshow检验)、基于数据驱动设定概率阈值、仅提供表观性能指数(无内外部验证)、校准图存在错误,判断为“可能不是/不是”。

5 示例分析

本研究以《基于机器学习构建急性心力衰竭患者易损期死亡或再入院风险预测模型》[24](以下简称“示例研究”)为例,使用PROBAST+AI工具对其进行质量、偏倚风险和适用性评价。

第一步,明确系统评价的目的。拟开展一项“机器学习方法应用于心衰易损期患者预后预测模型的系统评价”研究。有关该系统评价的PICOTS定义标准和示例研究的比较见表6。第二步,预测模型分类。示例研究使用6种ML算法开发6个新的预后模型,并在测试集中内部验证,未使用外部数据集进行外部验证,属于模型开发和内部验证研究。第三步,评估各领域预测模型的质量、偏倚风险和适用性。模型开发部分领域1,示例研究的数据来源于医院心内科住院的651例心衰患者,属于前瞻性队列研究,纳排标准合理,所纳入的研究对象与系统评价的问题相符,因此,3个标志性问题均判断为“是”,该领域质量为“高质量”,适用性评价为“高适用性”。领域2,示例研究通过医院电子病历系统收集预测因子信息,相关理化指标由医院专业技术人员测定,预测因子的处理方式一致,且在不知晓结局情况下测定,模型使用时可以获取,与系统评价的问题相符,因此4个标志性问题为“是”,该领域质量为“高质量”,适用性评价为“高适用性”。领域3,示例研究采用复合结局,与系统评价问题相符,因此4个标志性问题为“是”,该领域质量为“高质量”,适用性评价为“高适用性”。领域4,示例研究每变量事件数(events per variable,EPV)值为22(发生终点事件157例/纳入的预测因子数7),未对连续或分类预测因子特殊处理,删除缺失>20%的预测因子并使用K近邻插补法填充数据,应用最小绝对收缩和选择算子(LASSO)算法筛选预测因子,未使用处理类别不平衡的方法,因此标志性问题1、2、5判断为“是”,标志性问题3判断为“不是”,标志性问题4判断为“不适用”,该领域质量为“低质量”。模型评估部分,由于训练集和测试集数据来源相同,前3个领域的判定与模型开发部分相同,均为“低偏倚风险”,适用性评价均为“高适用性”。领域4,未评估模型的表观性能,仅评估内部验证性能;测试集样本量不足,仅46例发生终点事件;数据拆分后没有数据泄露;删除缺失>20%的预测因子并使用K近邻插补法填充数据,未使用处理类别不平衡的方法和重采样技术,未评估模型的校准度,因此标志性问题1、5判断为“是”,标志性问题2、3、7判断为“不是”,标志性问题4、6判断为“不适用”,最终判断该领域为“高偏倚风险”。第四步,整体评价。模型开发部分4个领域的质量判定为“高、高、高、低”,前3个领域适用性评价均为“高”,因此模型开发的整体研究质量较低,模型适用性较高;模型评估部分4个领域的偏倚风险判定为“低、低、低、高”,前3个领域适用性评价均为“高”,因此,虽然模型整体适用性较高,但存在高偏倚风险。

6 讨论

PROBAST+AI工具最值得注意的变化是明确区分:模型开发侧重于评价其方法学质量,模型评估侧重于评价其偏倚风险。模型开发是实际构建或制造预测模型的过程,相对于评估模型性能,应更加关注在数据收集、研究设计和实施以及数据分析过程中是否存在方法学缺陷或疏漏。若存在缺陷,可能导致在性能评估或应用于新个体时预测准确性及可靠性较低。因此,引入方法学质量的概念用于评估模型开发过程中潜在的质量问题。模型评估是应用性能指标(如区分度、校准度)估计或量化预测性能的过程,一个模型只被开发一次,但是可以在不同的数据集上进行多次评估或验证。当模型评估过程存在缺陷时,可能会导致模型性能估计值系统性偏离(高估或低估)其真实性能,即产生偏倚。因此,该部分通过一系列问题判断模型评估过程中潜在的偏倚风险。若研究中报告了模型的开发和评估,应使用PROBAST+AI工具单独评估两部分内容。

PROBAST+AI工具在4个领域中特别强调了预测模型开发和评估研究中的公平性问题,尤其是使用AI/ML算法的研究。公平性的一方面是预测模型的设计和应用避免对任何个体或群体造成不利歧视;另一方面是确保用于模型开发和评估的数据集具备多样性和代表性。否则,由此产生的模型既不有效,也不公平,并且模型在特定亚组中所表现的预测性能也会存在偏差。这有助于判断预测模型是否具备良好的泛化能力、可推广性及可移植性。

此外,随着数据基础设施和医疗大数据平台的不断发展,由此产生的海量、非结构化、多源异构数据信息(例如公共数据库、真实世界数据)的可及性日益增加。当使用此类数据集进行模型开发和评估时,严格仔细评估其数据质量尤为重要。此类数据并非专为预先设定的研究目的而收集,因而其中相关个体数据之间可能存在不同程度的异质性,例如对于同一预测因子和结局采用不同的定义及评估方式。

PROBAST+AI工具为研究者评估临床预测模型研究的质量、偏倚风险和适用性提供了最基本和最重要的项目内容和判断标准,有助于指导、规范预测模型的开发和(或)验证研究,提高和改善预测模型在医疗实践中的稳健性、有效性、适用性以及公平性,有助于减少研究资源的浪费。因此,推荐进行临床预测模型研究的所有相关人员积极学习、规范使用并推广PROBAST+AI工具,创建更加规范和高质量的临床预测模型研究生态,使之能够更加精准和有效的辅助临床决策。

利益冲突:无。

作者贡献:王兴蒙提出论文整体架构、作图表、负责论文撰写及修改;戴国华、高武霖提出论文选题并负责修改论文框架、终审论文;管慧、任丽丽负责修改论文框架、复核表格内容;陈晨、谭晓阳、林一鸣负责文献翻译、参与撰写初稿。

- 搜索

-

- 1000℃李寰:先心病肺动脉高压能根治吗?

- 1000℃除了吃药,骨质疏松还能如何治疗?

- 1000℃抱孩子谁不会呢?保护脊柱的抱孩子姿势了解一下

- 1000℃妇科检查有哪些项目?

- 1000℃妇科检查前应做哪些准备?

- 1000℃女性莫名烦躁—不好惹的黄体期

- 1000℃会影响患者智力的癫痫病

- 1000℃治女性盆腔炎的费用是多少?

- 标签列表

-

- 星座 (702)

- 孩子 (526)

- 恋爱 (505)

- 婴儿车 (390)

- 宝宝 (328)

- 狮子座 (313)

- 金牛座 (313)

- 摩羯座 (302)

- 白羊座 (301)

- 天蝎座 (294)

- 巨蟹座 (289)

- 双子座 (289)

- 处女座 (285)

- 天秤座 (276)

- 双鱼座 (268)

- 婴儿 (265)

- 水瓶座 (260)

- 射手座 (239)

- 不完美妈妈 (173)

- 跳槽那些事儿 (168)

- baby (140)

- 女婴 (132)

- 生肖 (129)

- 女儿 (129)

- 民警 (127)

- 狮子 (105)

- NBA (101)

- 家长 (97)

- 怀孕 (95)

- 儿童 (93)

- 交警 (89)

- 孕妇 (77)

- 儿子 (75)

- Angelababy (74)

- 父母 (74)

- 幼儿园 (73)

- 医院 (69)

- 童车 (66)

- 女子 (60)

- 郑州 (58)